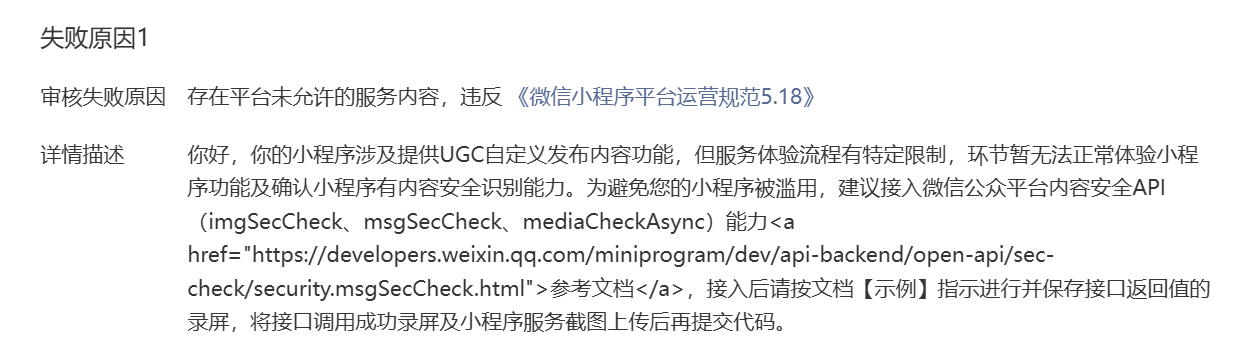

Hadoop大数据基础学习笔记

Hadoop大数据基础学习笔记

何平安观前提醒:先学会Linux操作系统和数据库后再来~

虚拟机集群配置

Linux操作系统有很多版本,这里选择的是Centos,先安装虚拟机VMware,然后再下载Centos的镜像

进去后直接新建虚拟机选择典型,然后地址就是刚刚下载的虚拟机的位置,内存分配建议它建议的一半就行(要是你电脑好当我没说),安装(时间可能有10分种左右)。登录选择“未列出的列表”,然后username输入root,密码就是刚刚创建时的密码。进去后右键桌面,选择最下面的terminal打开终端,然后输入hostnamectl set-hostname node1,意思就是将主机名设置为node1。

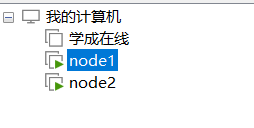

然后关闭虚拟机,左边任务栏右键刚刚的虚拟机选择克隆:

选择克隆完整的虚拟机,就是跟这个一模一样的。然后按照上面的方法再克隆1个,接着重命名主机名分别为node2,node3

配置虚拟机ip和网关:左上角编辑选择虚拟机网络编辑器,然后选择vmnet8,更改设置,将子网ip设置为192.168.88.0,NAT设置里网关设置为192.168.88.2

打开node1终端输入vim /etc/sysconfig/network-scripts/ifcfg-ens33

改下:BOOTPROTO=”static”

添加:

IPADDR=”192.168.88.101”

NETMASK=”255.255.255.0”

GATEWAY=”192.168.88.2”

DNS1=”192.168.88.2”

然后ctrl+c输入’:wq’保存并退出,输入:systemctl restart network重启网络,然后输入ifconfig查看ip网络。

node2/node3就是将IPADDR这一行分别改为 192.168.88.102和192.168.88.103,其它的都一样

改用FinalShell操作

新建SSH连接,主机输入192.168.88.101….102……103,用户输入root,密码就是自己的

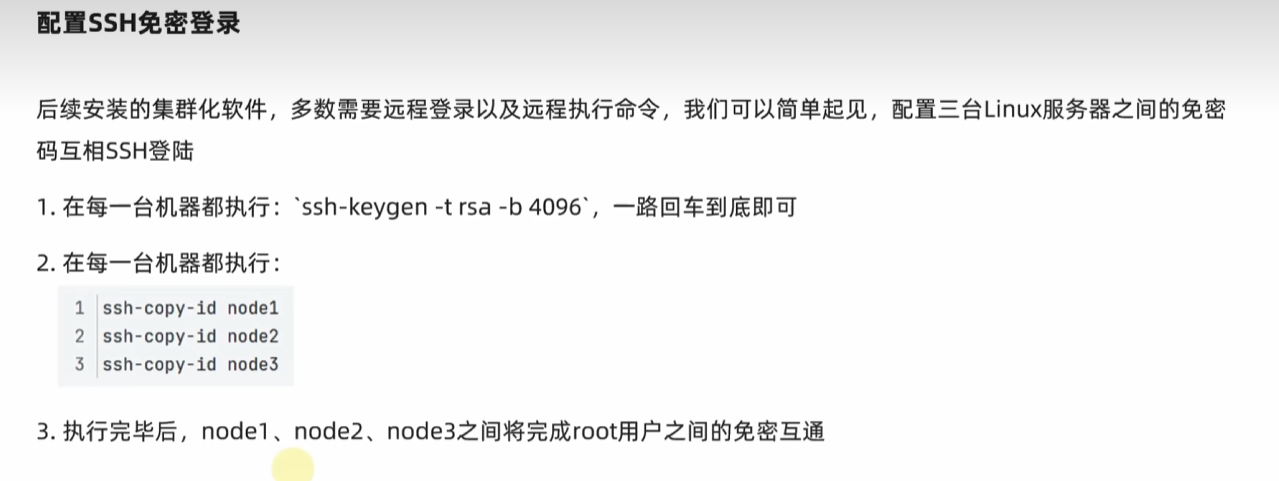

配置SSH免密登录:先输入ssh-keygen -t rsa -b 4096,一直回车,然后分别输入

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node3

这样就可以在一个服务器上登录其它服务器了。

创建新用户

useradd hadoop

passwd hadoop

su - hadoop

ssh-keygen -t rsa -b 4096

ssh-copy-id node1

ssh-copy-id node2

ssh-copy-id node3

三台机子都重复一遍

配置Java环境

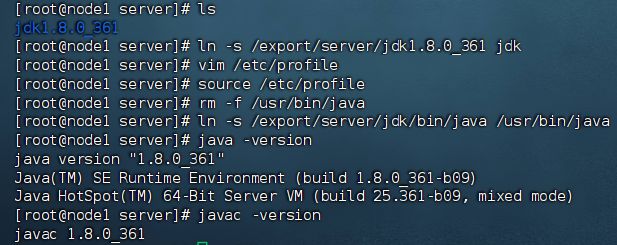

下载Linux版的jdk1.8:2024最新版黑马程序员大数据学习路线图_免费高速下载|百度网盘-分享无限制 (baidu.com),在终端输入mkdir -p /export/server新建一个文件夹,再rz将刚刚下载的jdk导入,然后输入tar -zxvf jdk-8u361-linux-x64.tar.gz -C /export/server解压,cd /export/server和ls检查下解压好没,然后输入ln -s /export/server/jdk1.8.0_361 jdk 配置jdk软链接;

配置环境变量:输入 vim /etc/profile打开环境变量,然后输入export JAVA_HOME=/export/server/jdk和export PATH=$PATH:$JAVA_HOME/bin,保存退出;然后输入source /etc/profile生效环境变量,接着删除centos自带的java并将自己的java替换进入:

rm -f /usr/bin/java

ln -s /export/server/jdk/bin/java /usr/bin/java

然后就可以输入java -version和javac -version检查java环境了。每个node都是一样的,可以先输入scp -r /export/server/jdk1.8.0_361 node2:pwd/将jdk复制到node2中

同样三个都要

防火墙,SELinux,时区

关闭防火墙:systemctl stop firewalld和systemctl disable firewalld(关闭开机自启),实际开发中肯定不这么做。

设置SELinux:vim /etc/sysconfig/selinux进入将SELINUX设置为disabled

配置时区,为了防止每个服务器时间不一样:先安装ntp:yum install -y ntp

rm -f /etc/lcoaltime;sudo ln -s /usr/share/zoneinfo/Asia/Shanghai /etc/localtime

虚拟机/服务器部署HDFS集群

先下载 hadoop的官方安装包,然后先上传到node1节点的/export/server文件夹中并解压:tar -zxvf hadoop-3.3.4.tar.gz -C /export/server